Software wägt ethische Entscheidungen differenzierter ab

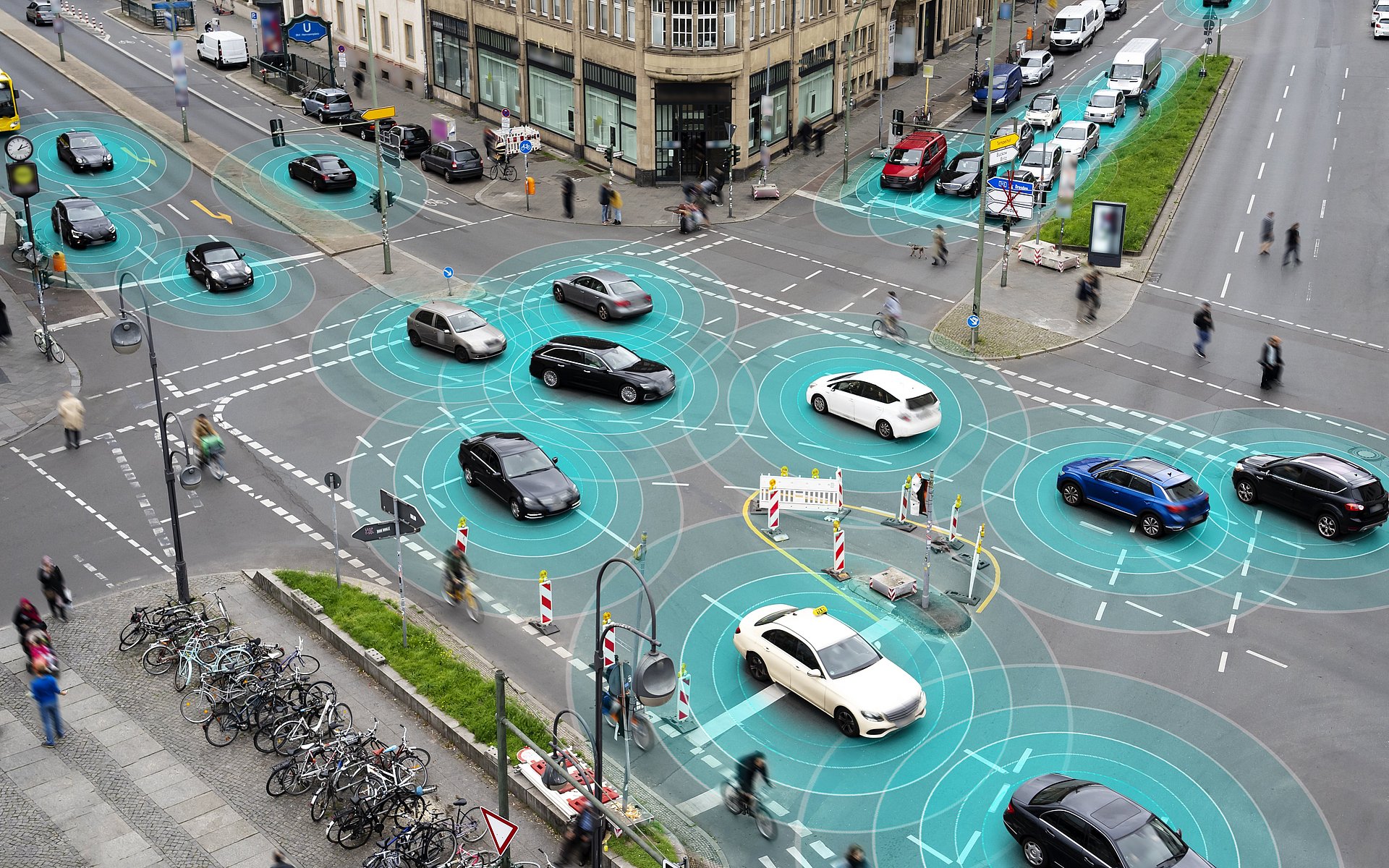

Autonomes Fahren: Neuer Algorithmus verteilt Risiken fair

Bevor autonom fahrende Fahrzeuge flächendeckend auf den Straßen unterwegs sein können, muss nicht nur die technische Umsetzung bewerkstelligt werden. Auch ethische Fragen spielen bei der Entwicklung von Algorithmen eine wichtige Rolle. So muss die Software mit unvorhersehbaren Situationen umgehen können und im Falle eines drohenden Unfalls die notwendigen Entscheidungen treffen. Forschende der TUM haben nun erstmals einen ethischen Algorithmus entwickelt, der nicht nach der Maxime entweder/oder handelt, sondern Risiko fair aufteilt. Rund 2.000 Szenarien mit kritischen Situationen wurden dabei getestet, verteilt auf unterschiedliche Straßentypen und Gebiete wie Europa, die USA und China. Die Forschungsarbeit, die im Fachjournal „Nature Machine Intelligence“ veröffentlicht wurde, entstand in Zusammenarbeit der Lehrstühle für Fahrzeugtechnik und für Wirtschaftsethik am Institute for Ethics in Artificial Intelligence (IEAI) der TUM.

Maximilian Geißlinger, Wissenschaftler am Lehrstuhl für Fahrzeugtechnik, erklärt den Ansatz so: „Bislang wurden autonome Fahrzeuge im Falle einer ethischen Fragestellung immer vor die Entscheidung entweder/oder gestellt. Allerdings lässt sich der Straßenverkehr nicht in schwarz und weiß einteilen, sondern bedarf auch der Betrachtung der unzähligen Graustufen. Unser Algorithmus wägt verschiedene Risiken ab und trifft aus tausenden möglichen Verhaltensweisen eine ethische Entscheidung – und das in Sekundenbruchteilen.“

Mehr Optionen in kritischen Situationen

Die ethischen Rahmenbedingungen, an denen sich die Risikobewertung der Software orientiert, hat eine Expert:innenrunde im Auftrag der EU-Kommission 2020 in einem Empfehlungsschreiben definiert. Es beinhaltet Grundsätze wie den Schutz schwächerer Verkehrsteilnehmender und die Aufteilung von Risiko im gesamten Straßenverkehr. Damit diese Regeln in mathematische Berechnungen übertragen werden konnten, teilte das Forschungsteam Fahrzeuge und Personen, die sich im Verkehr bewegen, anhand des von ihnen ausgehenden Risikos für andere und anhand ihrer unterschiedlichen Risikobereitschaft ein. Ein Lastwagen kann anderen Verkehrsteilnehmenden großen Schaden zuführen, während er selbst in vielen Szenarien nur in kleinerem Maße beschädigt wird. Bei einem Fahrrad ist es umgekehrt. Im nächsten Schritt wurde dem Algorithmus vorgegeben, in den verschiedenen Verkehrssituationen ein maximal akzeptables Risiko nicht zu überschreiten. Außerdem kalkulierte das Forschungsteam Variablen ein, die aus der Verantwortung der Verkehrsteilnehmenden resultieren, beispielsweise sich an Verkehrsregeln zu halten.

Bisherige Ansätze behandelten kritische Situationen auf der Straße nur mit einer geringen Anzahl möglicher Manöver. Im Zweifel blieb das Fahrzeug einfach stehen. Durch die nun in den Code eingebrachte Risikobewertung entstehen mehr Freiheitsgrade bei weniger Risiko für alle. Anhand eines Beispiels wird der Ansatz deutlich: Ein autonomes Fahrzeug möchte ein Fahrrad überholen, auf der Gegenfahrspur kommt ihm ein Lkw entgegen. Alle vorhandenen Daten über die Umgebung und die einzelnen Teilnehmenden werden nun zu Rate gezogen. Lässt sich das Rad überholen, ohne in die Gegenfahrspur zu fahren und gleichzeitig genug Abstand zum Fahrrad zu halten? Welches Risiko besteht für welches Fahrzeug und welches Risiko bedeuten diese Fahrzeuge für einen selbst? Im Zweifel wird das autonome Gefährt mit der neuen Software immer warten, bis das Risiko für alle akzeptabel ist. Aggressive Manöver werden vermieden, gleichzeitig fällt das selbstständig fahrende Fahrzeug nicht eine Schockstarre und bremst abrupt ab. Ja und Nein spielen keine Rolle, es findet eine Abwägung statt, die viele Optionen beinhaltet.

„Traditionelle ethische Denkmuster führten in Sackgasse“

„Bislang wurden häufig traditionelle ethische Denkmuster gewählt, um Entscheidungen autonomer Fahrzeuge zu begründen. Das führte letztlich in eine Sackgasse, weil in vielen Verkehrssituationen nichts anderes übrig blieb, als ein ethisches Prinzip zu verletzen“, sagt Franziska Poszler, Wissenschaftlerin am Lehrstuhl für Wirtschaftsethik der TUM. „Wir dagegen betrachten den Verkehr mit der Risikoethik als zentralem Ausgangspunkt. Das ermöglicht uns, mit Wahrscheinlichkeiten zu arbeiten und differenzierter abzuwägen.“

Die Forschenden betonen, dass auch Algorithmen, die nach der Risikoethik handeln, zwar jegliche mögliche Situation abdecken und eine Entscheidung auf Basis von ethischen Prinzipien treffen, aber dennoch keinen unfallfreien Straßenverkehr garantieren können. Künftig müssten zudem weitere Differenzierungen wie etwa kulturelle Unterschiede in ethischen Entscheidungen berücksichtigt werden.

Software wird nun im Straßenverkehr getestet

Der an der TUM entwickelte Algorithmus wurde bislang in Simulationen validiert. Mit dem Forschungsfahrzeug EDGAR wird die Software künftig auch auf der Straße getestet. Der Code, in den die Erkenntnisse der Forschungsarbeit fließen, steht Open Source zur Verfügung. Damit trägt die TUM zur Entwicklung praktikabler und sicherer autonomer Fahrzeuge bei.

M. Geisslinger, F. Poszler, and M. Lienkamp, “An ethical trajectory planning algorithm for autonomous vehicles,” Nat Mach Intell, 2023. DOI: 10.1038/s42256-022-00607-z

Projekt „ANDRE – AutoNomous DRiving Ethics“

https://www.ieai.sot.tum.de/research/andre-autonomous-driving-ethics/

Technische Universität München

Corporate Communications Center

- Andreas Huber

- huber.a@tum.de

- presse@tum.de

- Teamwebsite

Kontakte zum Artikel:

Franziska Poszler, M.Sc. | Maximilian Geißlinger. M.Sc. |