Zur Waldkartierung und Inspektion von Schiffen vorgesehen

Räumliche KI: Wie Drohnen sich zurechtfinden

Bei Menschen läuft alles automatisch ab: Sie erkennen Objekte und ihre Eigenschaften, können Abstände und Gefahren einschätzen, mit anderen Menschen interagieren. Stefan Leutenegger spricht von einer kohärenten 3D-Repräsentation der Umgebung, einem einheitlichen Gesamtbild. Eine Drohne zu befähigen, statische von dynamischen Elementen zu unterscheiden und andere Akteure zu erkennen: Das ist einer der wichtigen Aufgabenbereiche des Professors für maschinelles Lernen in der Robotik an der TUM, der zudem Leiter des Innovationsfeldes künstliche Intelligenz im Munich Institute of Robotics and Machine Intelligence (MIRMI) ist.

Räumliche KI Schritt 1: Position des Roboters im Raum einschätzen und diesen kartographieren

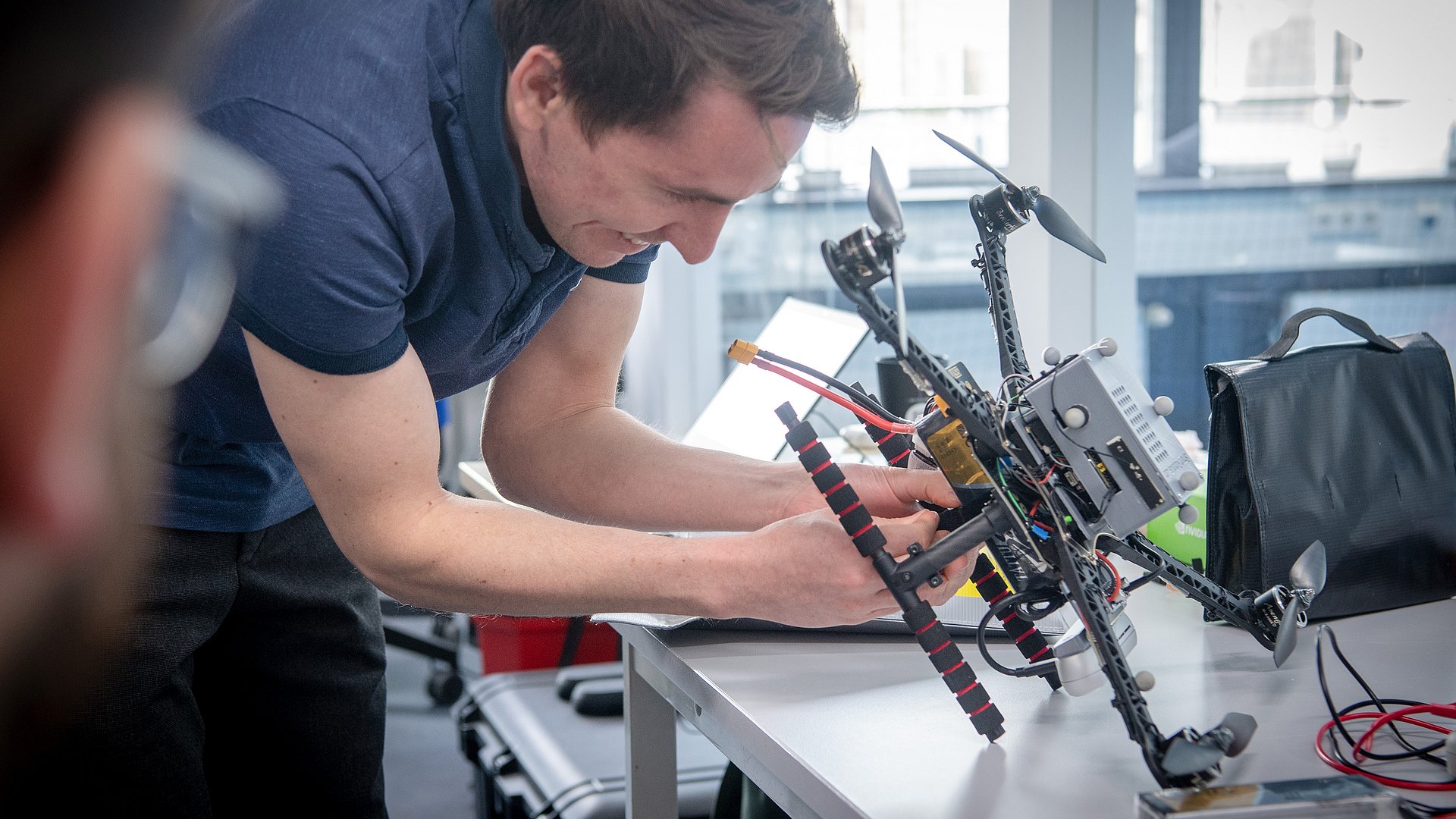

Leutenegger setzt auf „Spatial AI“, um einer Drohne die nötige Intelligenz mit an Bord zu geben, damit sie künftig durch einen Wald fliegen kann, ohne gegen feine Äste zu prallen, um dreidimensional zu drucken oder Laderäume von Tankern oder Frachtern zu inspizieren. Spatial AI – übersetzt bedeutet es so viel wie räumliche künstliche Intelligenz – setzt sich aus mehreren Bausteinen zusammen, die je nach spezifischer Aufgabe angepasst werden und an deren Anfang die Wahl der Sensoren steht:

- Computervision: Über eine oder zwei Kameras nimmt die Drohne die Umwelt wahr. Für das Tiefensehen sind – wie beim Menschen zwei Augen – zwei Kameras nötig. Leutenegger nutzt zwei Sensoren, deren Bilder er gegeneinander abgleicht, um eine Tiefenwahrnehmung zu bekommen. Zudem gibt es Tiefenkameras, die das Bild in drei Dimensionen direkt ausgeben.

- Inertial- oder Trägheitssensoren: Diese Sensoren messen die Beschleunigung und Winkelgeschwindigkeit und erfassen damit die Bewegung von Körpern im Raum.

„Visuelle und inertiale Sensoren ergänzen sich sehr gut“, sagt Leutenegger. Denn werden deren Daten miteinander fusioniert, entsteht ein sehr genaues Bild über die Bewegung der Drohne und der statischen Umgebung. Das Gesamtsystem ist also in der Lage, die eigene Position im Raum einzuschätzen. Das ist die Voraussetzung etwa für den autarken Einsatz von Robotern. Dabei kann die statische Umgebung auch sehr detailliert und dicht kartographiert werden. Das ist eine wichtige Voraussetzung dafür, Hindernissen auszuweichen. Hier kommen zunächst mathematische und probabilistische Modelle (aus der Wahrscheinlichkeitsrechnung) und keine künstliche Intelligenz zum Einsatz. Deswegen spricht Leutenegger hier von untersten Level von „Spatial AI“ – einem Thema, das Leutenegger zudem schon vor seiner Zeit an der TUM am Imperial College in London erforscht hat.

Räumliche KI Schritt 2: Neuronale Netze für das Verstehen der Umgebung

Künstliche Intelligenz in Form von neuronalen Netzwerken spielt eine wichtige Rolle, um die Umgebung semantisch zu erfassen. Hier geht es dann um das tiefere Verstehen der Umgebung um den Roboter. Über Deep Learning lässt sich erfassen und digital auf der Karte darstellen, welche für Menschen verständliche Kategorien genau auf dem Bild zu sehen sind. Dafür nutzen neuronale Netze die Bilderkennung von 2-D-Bildern, die dann in einer 3D-Karte dargestellt wird. Der Aufwand für die Erkennung durch Deep Learning hängt davon ab, wie viele Details erfasst werden sollen, um eine Spezialaufgabe erfüllen zu können. Einen Baum von Boden und Himmel zu unterscheiden ist einfacher, als den Baum oder sogar dessen Gesundheitszustand exakt zu bestimmen. Für derart spezielle Bilderkennung fehlen oft die Daten, die die neuronalen Netze zum Lernen benötigen. Deshalb besteht ein Ziel von Leuteneggers Forschung darin, Methoden des maschinellen Lernens zu entwickeln, die mit spärlichen Trainingsdaten effizient umgehen können sowie die Roboter während ihres Einsatzes kontinuierlich weiterlernen zu lassen. In einer noch weiterführenderen Form räumlicher KI geht es darum, dass Objekte oder gar Teile eines Objektes erkannt werden, sogar wenn sie sich bewegen.

Die aktuellen KI-Projekte des MIRMI-Professors: Waldkartierung, Inspektion von Schiffen, Baurobotik

Die räumliche künstliche Intelligenz kommt bereits in drei Forschungsprojekten zum Einsatz:

- Mauern bauen: In der Baurobotik kommt ein mobiler Roboter zum Einsatz, der mit Greifern (Manipulatoren) ausgestattet ist. Seine Aufgabe im vom Georg Nemetschek Institut über vier Jahre geförderten Projektes SPAICR besteht darin, „Strukturen“ wie etwa Mauern auf- und abzubauen. Die besondere Herausforderung in dem Projekt, in dem Leutenegger mit TUM-Professorin Kathrin Dörfler (Professur für Digitale Fabrikation) zusammenarbeitet, wird sein, dass die Arbeit des Roboters ohne so genanntes Motion Tracking, also ohne externe Infrastruktur, funktionieren soll. Während in vorhergehenden Forschungen ein klar begrenzter Raum mit Orientierungspunkten in einem Labor genutzt wurde, soll der Roboter künftig auf jeder beliebigen Baustelle präzise arbeiten können.

- Den Wald digitalisieren: Im EU-Projekt Digiforest schaffen die Universität Bonn, die Universität Oxford, die ETH Zürich, die Norwegian University of Science and Technology und die TUM eine „Datengrundlage für eine ökologische Forstwirtschaft“. Dafür soll der Wald kartographiert werden. Wo steht welcher Baum? In welcher gesundheitlichen Situation befindet er sich? Gibt es Krankheiten? Wo muss ausgedünnt, wo aufgeforstet werden? „Die Forschungen sollen dem Förster zusätzliche Informationen zur Entscheidungsfindung liefern“, erläutert Leutenegger. Aufgabe der TUM: Die KI-Drohnen von Leutenegger sollen autonom durch den Wald fliegen und ihn kartieren. Dabei sollen sie trotz Wind und dünner Äste um Bäume herum navigieren, so dass eine vollständige Karte des Waldstückes entsteht.

- Schiffe inspizieren: Im EU-Projekt AUTOASSESS geht es darum, Drohnen in das Innere von Tankern und Frachtern zu schicken, mit der Aufgabe, die Innenwände zu inspizieren. Dafür werden sie unter anderem mit Ultraschallsensoren ausgestattet, mit denen sie Risse in Wänden nachweisen können. Voraussetzung wird sein, dass sich die Drohnen autonom und bei schlechter Funkverbindung im Innenraum bewegen können. Auch hier ist ein Motion Tracking nicht möglich.

Spatial AI schafft Basis für Entscheidungen

„Wir arbeiten daran, in ganz verschiedenen Bereichen Menschen eine gute Datenbasis an die Hand zu geben, um die richtigen Entscheidungen zu treffen“, sagt Prof. Leutenegger, der betont: „Unsere Roboter sind komplementär, sie ergänzen den Menschen in seinen Fähigkeiten und nehmen ihm gefährliche und repetitive Aufgaben ab.“

Z. Landgraf, R. Scona, S. Leutenegger et al: SIMstack: A Generative Shape and Instance Model for Unordered Object Stacks; https://ieeexplore.ieee.org/document/9710412

S. Zhi, T. Laidlow et al: In-Place Scene Labelling and Understanding with Implicit Scene Representation; https://ieeexplore.ieee.org/document/9710936

G. Gallego, T. Delbrück, S. Leutenegger et al: Event-Based Vision: A Survey; https://ieeexplore.ieee.org/document/9138762

Prof. Stefan Leutenegger ist Principal Investigator und Leiter des Innovationsfeldes künstliche Intelligenz im Munich Institute of Robotics and Machine Intelligence (MIRMI). Mit dem von Executive Director Prof. Sami Haddadin geführten MIRMI hat die TUM ein integratives Forschungszentrum für Wissenschaft und Technologie geschaffen, um innovative und nachhaltige Lösungen für zentrale Herausforderungen unserer Zeit zu erarbeiten. Die Einrichtung verfügt über führende Expertise auf zentralen Gebieten der Robotik, Perzeption und Data Science. Weitere Informationen finden Sie unter https://www.mirmi.tum.de/.

Technische Universität München

Corporate Communications Center

- Andreas Schmitz

- andreas.schmitz@tum.de

- +49 89 289 18198

- presse@tum.de

- Teamwebsite

Kontakte zum Artikel:

Prof. Dr. Stefan Leutenegger

Professor für Machine Learning in der Robotik

Leiter des Forschungsfelds künstliche Intelligenz im Munich Institute of Robotics and Machine Intelligence (MIRMI)

Technische Universität München

E-Mail: stefan.leutenegger@tum.de