Software FaceForensics erkennt Fake-Videos am zuverlässigsten

Künstliche Intelligenz enttarnt Fake-Videos

Vergangenes Jahr sorgte ein Video für Aufsehen, in dem Barack Obama Donald Trump als „kompletten Vollidioten“ beschimpft. Am Ende enttarnen die Macher das Video selbst als eine täuschend echte Manipulation. Mithilfe grafischer Verfahren wurde die Mimik einer anderen Person auf ein Video von Barack Obama übertragen, sodass ihm Worte in den Mund gelegt wurden, die er so wahrscheinlich nie gesagt hat. Solche Manipulationen sind mittlerweile in Echtzeit möglich, Videos können zu einer eingespielten Tonspur generiert oder stehende Bilder künstlich animiert werden – mit möglicherweise schwerwiegenden Folgen für Wirtschaft und Gesellschaft.

„Mit unserer Forschung verfolgen wir das Ziel, Videomanipulationen im Netz künftig einfacher aufspüren zu können.”— Matthias Nießner, Professor für Visual Computing

„Fake-Videos als solche zu erkennen, erweist sich besonders in den Sozialen Medien als schwierig, da diese dort meist komprimiert und schlecht aufgelöst hochgeladen werden“, sagt Prof. Matthias Nießner von der TUM. „Dieselben Methoden, die zur Manipulation von Videos genutzt werden, sind aber auch in der Lage, Fälschungen besonders zuverlässig aufzuspüren – selbst bei schlechter Bildauflösung.“

Umfangreicher Trainingsdatensatz für neuronale Netze

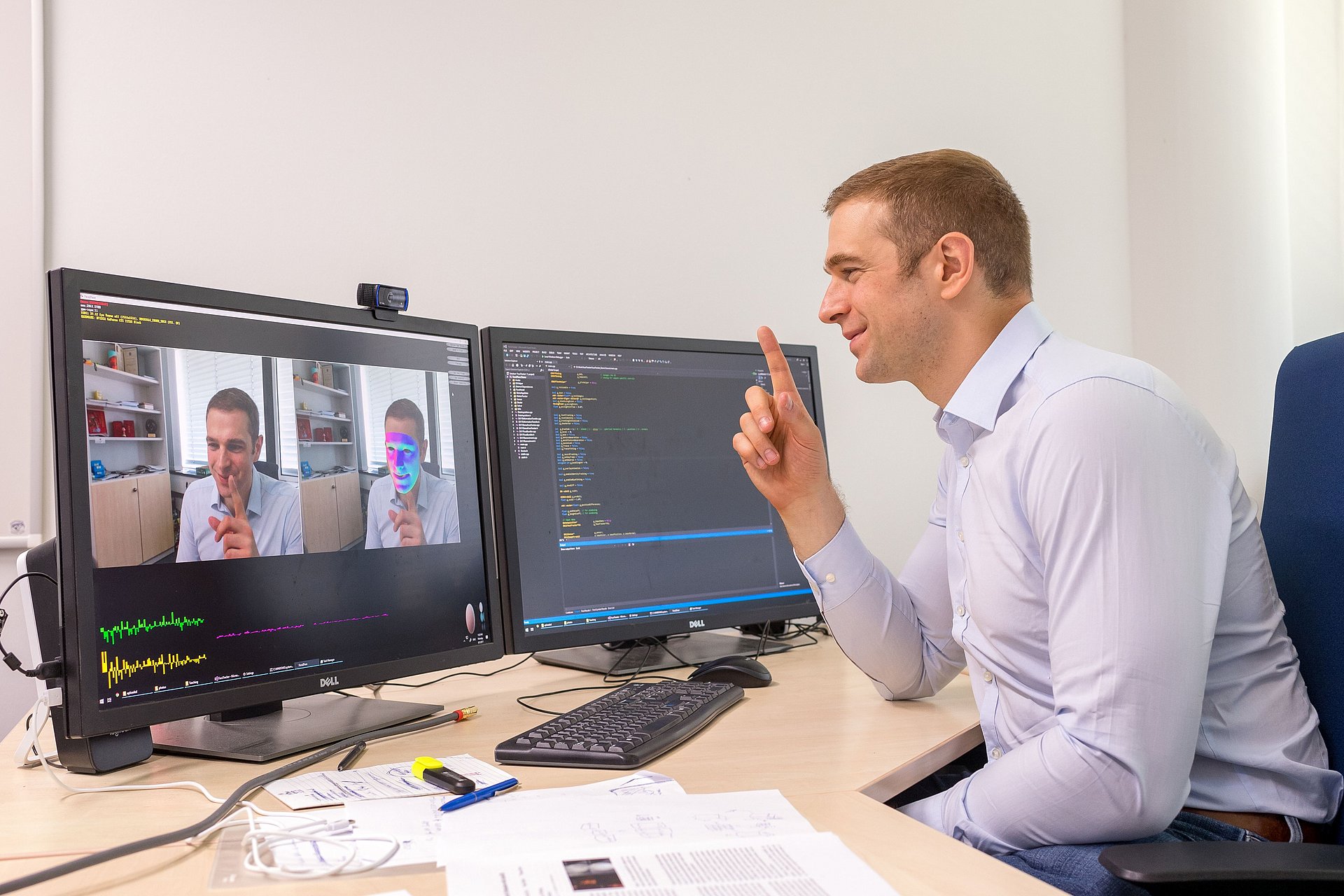

Damit eine künstliche Intelligenz entscheiden kann, ob ein Video manipuliert ist, muss sie Muster solcher Fälschungen wiedererkennen. Um erlenen zu können, was wiederkehrende Elemente sind, brauchen neuronale Netze einen gewaltigen Input an Fake-Videos. Da Forscherinnen und Forscher solche Videos bislang manuell mit Bild- und Videobearbeitungsprogrammen manipulieren mussten, fehlte es an der benötigten Menge solcher Trainingsdaten. Mit aktuellen DeepLearning-Methoden und grafischen Verfahren hat Nießner nun erstmals mit automatischen Verfahren einen umfangreichen Datensatz aufgebaut. Dazu nutze er unter anderem die von ihm entwickelte Software Face2Face, mit der sich die Mimik einer Person in Echtzeit auf eine andere Person übertragen lässt. Mithilfe des neuen Datensatzes konnte er seinen Algorithmus FaceForensics (++) mit mehr als einer halben Million Frames aus über tausend gefälschten Videos trainieren.

Gesicht im Fokus

„Als wir die neuronalen Netze mit unserem Datensatz trainiert haben, haben wir uns ganz besonders auf die Gesichtsregionen in den stehenden Bildern konzentriert“, sagt Andreas Rössler, Forscher im Visual Computing Lab der TUM. „Dank dieser Herangehensweise erkennt FaceForensics (++) Deepfakes und Videos, die mit Face2Face oder FaceSwap manipuliert wurden, besser als andere derzeit verfügbare Softwares.“ FaceForensics (++) übertrifft auch routinierte Expertinnen und Experten. Sind Fake-Videos stark komprimiert, identifizieren ungeübte Menschen diese laut Nießners Studie lediglich mit einer Wahrscheinlichkeit von knapp über 50% richtig, also nahezu zufällig. FaceForensics (++) ordnet hingegen 78 Prozent der einzelnen Frames und damit auch der Videos richtig ein.

„Mit unserer Forschung verfolgen wir das Ziel, Videomanipulationen im Netz künftig einfacher aufspüren zu können“, sagt Nießner. Deshalb hat sein Team FaceForensics (++) für die Communitys in den Bereichen KI, Grafik, Computer Vision und Digitale Forensik zugänglich gemacht. Anhand der von Nießner erstellten Daten kann auch die Zuverlässigkeit von anderen Erkennungsansätzen getestet und verglichen werden. Schon jetzt nutzen circa 200 Institutionen FaceForensics (++).

Nießner entwickelte FaceForensics in Zusammenarbeit mit Wissenschaftlerinnen und Wissenschaftlern der Università degli Studi di Napoli Federico II in Italien und der Friedrich-Alexander Universität Erlangen-Nürnberg. Das Projekt wurde finanziell von der AI Foundation unterstützt, die auch ein Browser Plugin für FaceForensics realisierte. Das Plugin kann Bilder und Videos, auf die Nutzerinnen und Nutzer im Internet treffen, automatisch daraufhin scannen, ob diese mithilfe von KI manipuliert wurden.

Technische Universität München

Corporate Communications Center

- Lisa Pietrzyk

- lisa.pietrzyk@tum.de

- +49 89 289-10516

- presse@tum.de

- Teamwebsite

Kontakte zum Artikel:

Prof. Dr. Matthias Nießner

Technische Universität München

Lehrstuhl für Visual Computing

Tel: +49 89 289-19556

niessner@tum.de

niessnerlab.org