Post-Quantum-sichere Kryptographie

Daten quantensicher verschlüsseln

Wir surfen ohne Bedenken im Internet, geben beim Online-Shopping unsere Bankdaten preis und nutzen ganz selbstverständlich Online-Banking. Wir gehen davon aus, dass unsere Daten verschlüsselt übertragen werden und dadurch sicher sind.

Doch was passiert, wenn unsere derzeit verwendeten Verschlüsselungstechniken nicht mehr sicher sind? Aktuell steckt hinter unserer Verschlüsselung die Idee, dass es schwierig ist, eine große Zahl in ihre Faktoren zu zerlegen. Sobald Quantencomputer leistungsfähig genug sind, um solche mathematischen Probleme zu lösen, wird sich dies jedoch ändern.

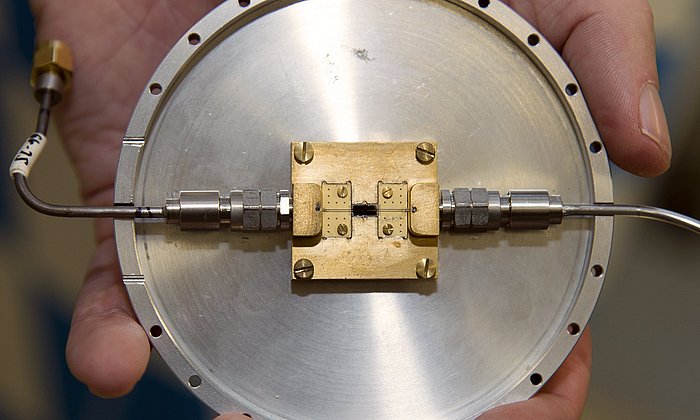

Verschlüsselungsverfahren werden in so gut wie allen elektronischen Geräten verwendet. Viele von ihnen besitzen eine sehr lange Lebensdauer und können nicht oder nur sehr aufwendig durch ein Update aktualisiert werden. Satellitenkommunikation ist hierfür ein Beispiel.

Wettbewerb für neue Verschlüsselungstechnologie

Das US-amerikanische National Institute of Standards and Technology (NIST) hat daher bereits 2016 in einem Wettbewerb dazu aufgerufen, neue quantensichere Verschlüsselungsstandards zu entwickeln. Diese sollen zukünftig auch Cyberangriffen mithilfe von Quantencomputern standhalten. Die eingereichten Algorithmen können öffentlich attackiert und so auf ihre Sicherheit geprüft werden. Die von der NIST standardisierten Verfahren werden in der Regel von Unternehmen und Online-Diensten übernommen, da sie als sehr sicher gelten.

In der ersten Runde des Wettbewerbs gab es insgesamt 69 Einreichungen. Die zweite Runde erreichten 26 der Algorithmen, sieben schafften es ins Finale. Kurz bevor die NIST die Sieger des Wettbewerbs küren wollte, wurden allerdings auch vier der Finalisten stark attackiert. Eines der Verfahren musste sogar aus dem Rennen genommen werden, da es innerhalb von zwei Tagen von einem handelsüblichen Laptop geknackt wurde. Die Schwachstellen der übrigen Algorithmen konnten soweit angepasst werden, dass sie weiter im Wettbewerb bleiben.

Trotz der vielen Einreichungen haben nur sehr wenige Algorithmen diesem K.O.-Rennen standgehalten. Das zeigt, wie wichtig es ist, Verfahren zu standardisieren, die auf unterschiedlichen mathematischen Problemen basieren. So können auch bei später erkannten Schwachstellen Verschlüsselungsmethoden ausgetauscht werden.

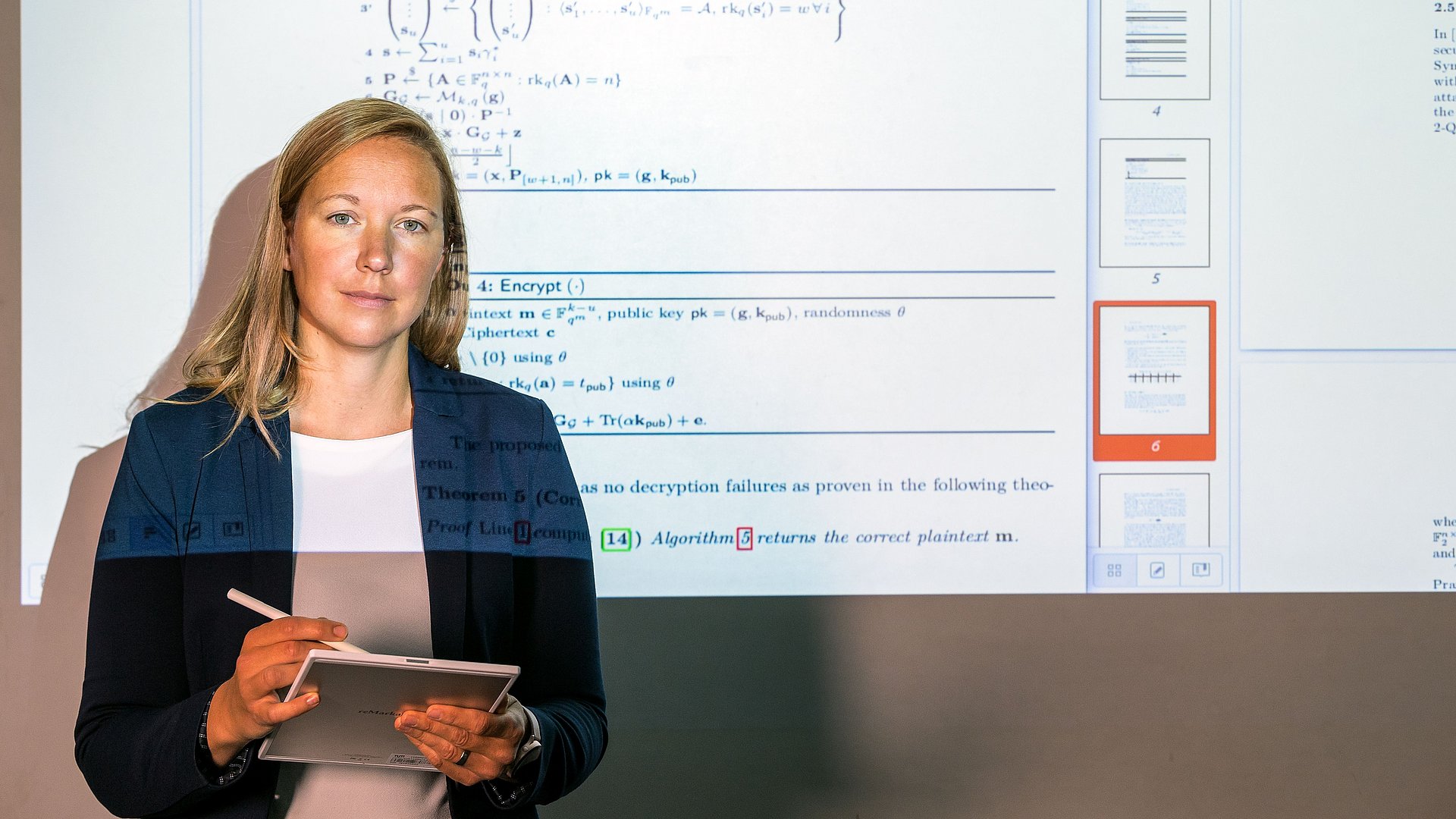

In diesem Frühjahr hat die NIST dazu aufgerufen, weitere Algorithmen einzureichen. Antonia Wachter-Zeh, Professorin für Codierung und Kryptographie an der TUM, hat gemeinsamen mit ihrem Team sowie einer weiteren Forschungsgruppe der TUM und Forschenden der Universita Politecnica delle Marche zwei Algorithmen im Bereich der digitalen Signaturen für den Wettbewerb entwickelt. Digitale Signaturen sind eine Art elektronischer Fingerabdruck, der sicherstellt, dass die Daten auch von dem erwarteten Sender stammen und nicht im Nachhinein verändert wurden.

„Wir müssen uns dringend mit neuen Verschlüsselungsverfahren auseinandersetzen, wenn wir wollen, dass unsere Daten in einigen Jahren noch sicher sind. Auch dann soll niemand in der Lage sein, das zu entschlüsseln, was wir heute kommunizieren“, sagt Antonia Wachter-Zeh.

Eingebaute Fehler garantieren sichere Verschlüsselung

Die von Prof. Wachter-Zeh eingereichten Algorithmen beruhen dabei auf fehlerkorrigierenden Codes. Dahinter steckt das Prinzip, dass beim Übertragen und Speichern von Daten oder auch beim Telefonieren im Mobilfunknetz ständig Fehler passieren. Im binären System wird an einer Stelle zum Beispiel fälschlicherweise statt der 0 die 1 übertragen. Bei fehlerkorrigierenden Codes werden vor der Übertragung redundante Informationen eingefügt, um diese, falls bei der Übermittlung Fehler passieren, korrigieren zu können. Dadurch ist es möglich, eine bestimmte Anzahl an Fehlern in den Daten auszugleichen.

Prof. Wachter-Zeh nutzt das Prinzip der fehlerkorrigierenden Codes zur Verschlüsselung von Daten, indem sie wissentlich vor der Übertragung Fehler einbaut. Diese werden später bei der Decodierung wieder herausgerechnet. Dadurch stellt die Forscherin sicher, dass die Informationen vor unbefugtem Zugriff geschützt sind, aber gleichzeitig auch wieder korrekt entschlüsselt und abgelegt werden können.

Für den NIST-Wettbewerb hat sich das Forschungsteam dazu entschieden, ein System basierend auf fehlerkorrigierenden Codes in der Lee Metrik und eins auf Grundlage restriktiver Fehler in der Hamming-Distanz einzureichen. Die klassische Hamming-Distanz gibt an, an wie vielen Stellen sich der Ausgangscode vom Code der Verschlüsselung unterscheidet. Im Gegensatz zur klassischen können bei der restriktiven Hamming-Distanz, die Fehler nur bestimmte Werte annehmen. Dafür können deutlich mehr Stellen fehlerhaft sein. Die Lee-Metrik gewichtet zusätzlich, wie sehr diese Stellen variieren.

„Das Signaturverfahren CROSS, welches restriktive Fehler nutzt, ist sehr kompetitiv und hat gute Erfolgschancen als neuer Verschlüsselungsstandard in Frage zu kommen. Bei unserem zweiten Algorithmus FuLeeca, der auf der Lee-Metrik basiert, wurden bereits Schwachstellen erkannt. Das Prinzip ist insgesamt dennoch vielsprechend aber recht neu. Daher wird hier noch einiges an Forschungsarbeit notwendig sein“, sagt Antonia Wachter-Zeh.

In der Kryptographie werden zwei unterschiedliche Methoden genutzt, um Daten zu verschlüsseln: zum einen die symmetrischen und zum anderen die asymmetrischen Verschlüsselungsverfahren. Asymmetrische Kryptosysteme basieren auf einem privaten und einem öffentlichen Schlüssel und werden als public-key Verfahren bezeichnet. Die beiden Kommunikationsteilnehmer:innen besitzen dabei jeweils ein Schlüsselpaar mit einem öffentlichen und einem privaten Schlüssel. Der öffentliche Schlüssel ist frei zugänglich, den privaten Schlüssel kennt nur der Besitzer bzw. die Besitzerin des Schlüsselpaares. Mithilfe des öffentlichen Schlüssels können Daten für den Besitzer bzw. die Besitzerin des privaten Schlüssels verschlüsselt werden. Der Empfänger bzw. die Empfängerin der Nachricht kann dann wiederum mit seinem bzw. ihrem privaten Schlüssel die Daten entschlüsseln.

Bei der symmetrischen Verschlüsselung besitzen beide Gesprächspartner:innen den gleichen Schlüssel, der geheim ausgetauscht werden muss. Um diesen Schlüssel allerdings weiterzugeben, wird auch hier auf das public-key Verfahren zurückgegriffen. Die Technik, dass der Schlüssel eines symmetrischen Verschlüsselungsverfahren mit einem asymmetrischen Verfahren übermittelt wird, wird als Schlüsselkapselungsverfahren bezeichnet.

Bei den symmetrischen Verfahren ist davon auszugehen, dass diese relativ leicht angepasst werden können und sie daher als quantensicher gelten. Der aktuelle NIST-Wettbewerb konzentriert sich aus diesem Grund auf asymmetrische Kryptosysteme und hierbei insbesondere auf digitale Signaturen und Schlüsselkapselungsverfahren.

- Die NIST ruft regelmäßig Wettbewerbe zu unterschiedlichen Themen aus, um so die IT-Sicherheit bei zu erwartenden Problemen sicherzustellen. Die Wettbewerbe sind dabei immer über mehrere Jahre ausgelegt, dauern mehrere Runden an und sind nach dem K.O. Prinzip aufgebaut.

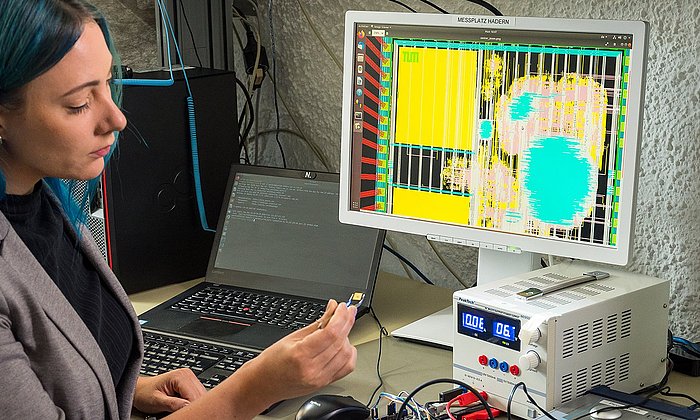

- Die Bewertung der einzelnen Einreichungen erfolgt im aktuell laufenden NIST-Wettbewerb nach drei Kriterien: Sicherheit, Performance und die Implementierungs-Charakteristika. Die Codes müssen in der Programmiersprache C eingereicht werden und der Quell-Code muss öffentlich zugänglich sein.

- Darüber hinaus ist Prof. Wachter-Zeh aktuell am deutsch-französischen DFG-ANR Projekt CROWD zu neuen Codeklassen in der Kryptographie beteiligt, bei dem sie Initiatorin und deutschseitige Koordinatorin ist, und am EiC Pathfinder Challenges Projekt DiDaX, das sich mit DNA Datenspeicherung beschäftigt.

- Die Arbeit von Prof. Wachter-Zeh wurde unter anderem durch das Emmy-Noether-Programm der DFG gefördert, durch das noch laufende ERC Projekt inCREASE („Coding for Security and DNA Storage“) sowie im Rahmen des BMBF-Projektes 6G-life. Neben vielen weiteren Preisen und Auszeichnung erhielt sie 2018 den Heinz Maier-Leibnitz-Preis sowie 2019 den NVMW Memorable Paper Award.

Technische Universität München

Corporate Communications Center

- Julia Rinner

- julia.rinner@tum.de

- presse@tum.de

- Teamwebsite

Kontakte zum Artikel:

Prof. Antonia Wachter-Zeh

Professur für Codierung und Kryptographie

antonia.wachter-zeh@tum.de

Tel: +49 89 289 – 23495